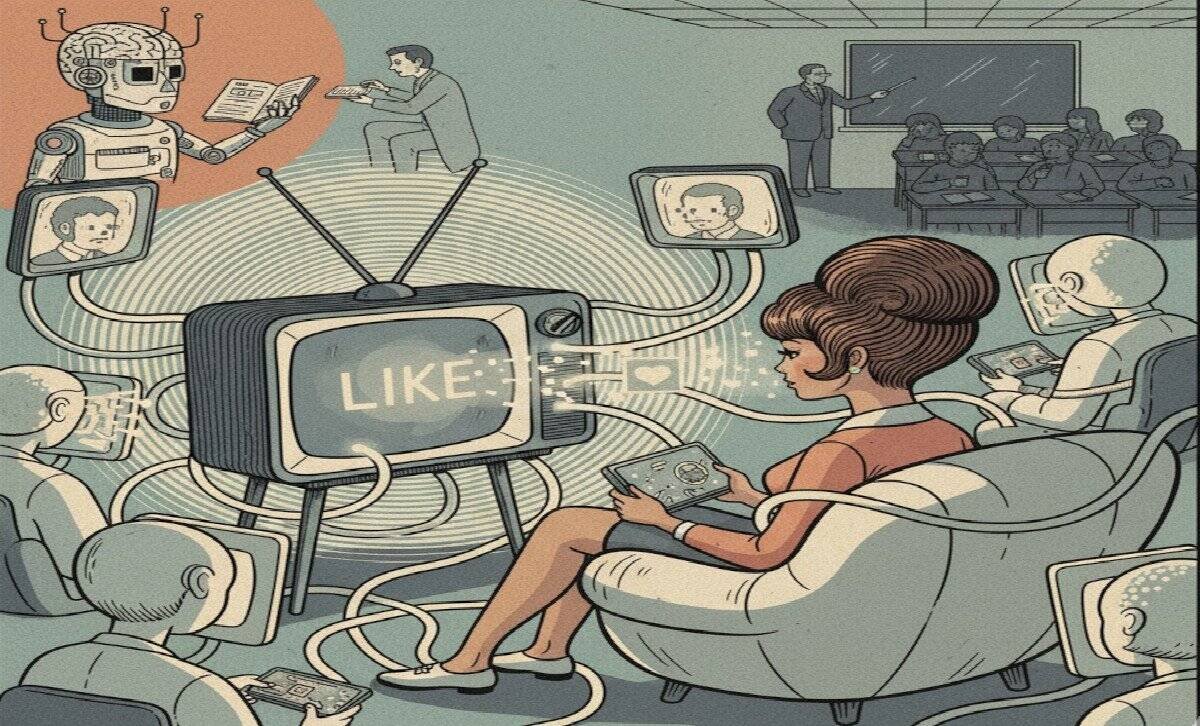

De la búsqueda del like a la deuda cognitiva

Desde que apareció el botón de Me gusta (Like) y las redes sociales, aproximadamente en el 2010, se ha reconfigurado el cerebro de las personas. La interacción social se trasladó a la pantalla, como zona de confort y seguridad se generó un ciclo de adicción o vicio impulsado por la recompensa dopaminérgica de la validación social, resultando una generación que pasa horas consumiendo contenido pasivamente, a menudo sin una interacción interpersonal genuina. Esta inmersión profunda tiene un costo cognitivo y social como disminución de habilidades interpersonales y pérdida de identidad – realidad.

La mediación ilimitada de la pantalla atrofia las habilidades de empatía, negociación, lectura de señales no verbales, esenciales para la convivencia y el trabajo en equipo. La realidad de muchas personas ya no se construye a partir de la experiencia directa, sino a través de los filtros, narrativas y patrones impuestos por los algoritmos de las redes sociales, lo que impulsa al riesgo de pérdida de identidad, donde el valor personal se mide por la métrica de la plataforma y parámetros definidos por “alguien” que solo le interesa el rédito económico.

La Sociedad de la Información centrada en la cantidad y el acceso a los datos ya no refleja la complejidad actual donde el problema no es la escasez sino la gestión estratégica y la influencia de los algoritmos. Así que hay que intentar acuñar términos que enfatizan la naturaleza algorítmica, la vigilancia o la interacción con sistemas inteligentes, podría ser Sociedad aumentada o híbrida, enfocada en que las capacidades cognitivas y físicas están constantemente asistidas y, a veces, creadas por la IA, reconociendo la necesidad de una hibridación cognitiva consciente.

La investigación del MIT Media Lab sobre la deuda cognitiva es contundente, cuando se delegan tareas cognitivas complejas a un Modelo de Lenguaje Grande (LLM), el cerebro humano se ejercita menos y muestra una conectividad neuronal reducida en las áreas de planificación y razonamiento abstracto.

Se pasa de ser un consumidor pasivo en redes (con deuda social) a ser un usuario pasivo de la IA (con deuda cognitiva), donde se externalizan funciones mentales complejas.

Ante la distracción y el vicio, la respuesta institucional ha sido la prohibición total del uso del celular en las aulas. Si bien parece que la intención es válida, evitar la dispersión, también parece que la propuesta “prohibir” no es insuficiente por algunos motivos, como ser:

- Ocultar la tecnología no prepara al estudiante para un mundo dominado por ella, sino que amplía la brecha entre quienes solo consumen horas en pantalla y quienes aprenden a controlar el uso.

- Si el acceso a las nuevas tecnologías, especialmente Inteligencia Artificial, se limita a un único dispositivo gestionado por el docente, el estudiante pasa a ser un espectador pasivo, impidiendo el desarrollo de la autonomía intelectual y la hibridación cognitiva consciente (saber cuándo delegar y cuándo trabajar solo).

La solución parece no ser técnica sino pedagógica y ética. Parece necesario un acuerdo para imponer limitaciones estratégicas y promover modalidades de uso que transformen la Inteligencia Artificial sustitutiva a un asesor, a partir de secuenciar su uso: fortaleciendo las habilidades fundamentales del estudiante sin asistencia tecnológica (escritura a mano, debate sin preparación digital) para después lograr una hibridación cognitiva consciente integrando la tecnología con un sentido epistemológico y cultural, enseñando con y sobre la IA, reconociendo que el conocimiento es provisorio.

Para transformar la salida de la IA en contenido confiable se requiere la curación experta, el valor final lo pone el humano mediante:

- Evaluar: juzgar la coherencia inicial.

- Verificar: contrastar datos y desconfiar siempre de información no confirmada (evitando alucinaciones).

- Enriquecer: incorporar la voz propia, la experiencia y el análisis experto (la subjetividad).

- Refinar: pulir el lenguaje para precisión y claridad.

El desafío es superar la adicción social del like y evitar la atrofia cerebral por la delegación de las redes sociales y a la IA. La alfabetización crítica en tecnología necesita de educadores que diseñen experiencias que exijan pensamiento profundo, creativo e independiente, para formar estudiantes que sepan cuándo delegar, cuándo colaborar y cuándo trabajar autónomamente, de tal forma de proteger su identidad, gestionar la información y convertir el algoritmo en un aliado de la libertad humana.

📚 Referencias y Bibliografía

Kosmyna, N. et al. (2025). Your Brain on ChatGPT: Accumulation of Cognitive Debt when Using an AI Assistant for Essay Writing Task. MIT Media Lab.

Maggio, M. (2012). Enriquecer la enseñanza: Los ambientes con alta disposición tecnológica como oportunidad. Paidós.

López, L. A. (2025). La deuda cognitiva de la IA. Publicación AKE/FUTURIALS.

López, L. A. (2025). Cómo la pedagogía puede transformar la tecnología educativa. Publicación AKE/FUTURIALS.

López, L. A. (2025). La interacción estratégica con la Inteligencia Artificial generativa. Publicación AKE/FUTURIALS.

UNESCO (2021). Recomendación sobre la Ética de la Inteligencia Artificial.

Comunicate con Nosotros

Preguntas frecuentes

¿En qué se diferencia un agente de IA de un chatbot?

El chatbot responde; el agente entiende objetivos, decide pasos y ejecuta acciones en tus sistemas, con límites y auditoría.

¿Qué tan “autónomo” puede ser hoy?

En pymes, autonomía acotada. Funciona muy bien con reglas y permisos claros; lo crítico pasa por revisión humana.

¿Cuánto cuesta arrancar?

El mayor costo inicial no siempre es la licencia: es ordenar datos y procesos. Empezá con un caso y un mes de piloto.

¿Suite, plataforma visual o framework?

Depende del contexto. Si ya vivís en una suite y te resuelve, usala. Si querés ir rápido, plataforma visual. ¿Lógica compleja? Framework con equipo técnico.¿Qué KPI miro primero?

Tasa de auto-resolución y tiempo de resolución. Te marcan el impacto sin vueltas.